Это старая версия документа!

Содержание

Нетрадиционный взгляд на историю вычислительной техники

Почему нетрадиционный?

Во-первых, обычно в книгах по истории вычислительной техники рассматриваются только собственно инженерные решения («железные», а иногда и программные), а я в этой статье рассматриваю их в связке, во-первых, с уровнем развития других отраслей техники в соответствующее время, во-вторых, с уровнем развития научных теорий (поскольку никакое техническое устройство не может появиться раньше той науки, на основании которой оно строится), и в-третьих, с вопросами применения компьютеров и программ в практической человеческой деятельности, а применение - в связке с экономическими и политическими реалиями соответствующей эпохи.

Во-вторых, в книгах вся история делится по поколениям компьютеров: первое - ламповое, второе - транзисторное и третье - микроэлектронное. Это неправильно с самого начала, поскольку ламповые машины уже были не первым поколением. Я же делю историю вычислительной техники на эпохи аналогичные тем, которые имели место в общечеловеческой истории.

Эта статья первоначально была задумана для школьников, но, написав половину, я понял, что это не мой репертуар, и решил перепрофилировать статью в серьезное научное исследование. Если она еще не стала таковой сейчас, то может быть станет в будущем. Но история - это нечто большее чем просто воспоминания о тех годах, когда солнышко было ярче и трава зеленее. История мне видится прежде всего как анализ причинно-следственных связей между событиями. Если вам это кажется неинтересным, ваше право на этом остановиться и дальше не читать, а я продолжу.

До середины ХХ века - первобытная эпоха

Когда появился первый компьютер?

На этот вопрос нет однозначного ответа. Во-первых, чем глубже интересуешься техникой, тем больше ощущаешь, что мы плохо знаем даже историю 30-40-летней давности, не говоря уж про более давние времена. Во-вторых, «первый компьютер» не возник на пустом месте - он вырос из каких-то более старых устройств. И в-третьих, мы не определились твердо, что считать компьютером, а что нет.

Начнем с того, что всевозможные вычислительные устройства типа счетов с нанизанными на проволоку костяшками были известны с глубокой древности, но компьютерами они не могут называться даже с очень большой натяжкой.

Леонардо да Винчи около 1500 года предложил счетную машинку с колесами. В последующие века было создано множество моделей машин, которые содержали колеса с нанесенными на них цифрами и по сути были потомками машинки Леонардо да Винчи. В XVII веке немец В. Шиккард, француз Б. Паскаль, голландец Г. Лейбниц предложили свои образцы механических калькуляторов, способных выполнять арифметические действия с многоразрядными числами.

Сейчас я хочу подвести читателя к мысли, которая будет лейтмотивом всей этой статьи. Эта мысль кажется очевидной для экономически грамотного человека, но раньше ни в каких книгах и статьях по вычислительной технике мне не встречалась. Мысль такая: вычислительная техника не живет в каком-то своем, отдельном, замкнутом мирке - она существует в мире, населенном людьми. А людям свойственно совершать поступки, руководствуясь не хочуками-нехочуками, а коммерческим интересом. В истории человечества новая техника появлялась много раз, и каждый раз она появлялась там и тогда, где и когда совпадали два условия: у людей накапливался для этой техники значительный объем работы, и за эту работу они были готовы платить. Так в XIX веке пароходы и железные дороги появились потому, что лошади больше не справлялись с возросшим объемом торговых грузоперевозок. А в XX веке автомобили и самолеты появились потому, что уже пароходы и железные дороги не справлялись… Но мы сейчас говорим о XVII веке, когда люди ездили на лошадях, дрались на шпагах, мололи хлеб на водяных мельницах, а по морю ходили под парусами. 90% населения голубого шарика были совершенно неграмотны, стало быть считать не умели, но жили без этого спокойно и ни в какой вычислительной технике не ощущали нужды. И замысловатые машинки с множеством прецизионных металлических деталей смотрелись как курьезы и могли заинтересовать только таких же чудаков, как и их создатели. Мы увидим, что и позже уровень развития вычислительной техники и ее распространенность на планете прямо коррелируются с уровнем грамотности населения.

Компьютерный палеолит - эпоха, когда никакие вычислительные устройства не имели перспектив ни промышленного производства, ни промышленного применения. Эта эпоха продолжалась до 1820 г., пока Т. де Кальмар во Франции не наладил промышленный выпуск колесных вычислительных машин, получивших название арифмометров. Основной областью применения арифмометров до самого окончания их выпуска была и осталась бухгалтерия. Позже арифмометры стали строиться и в других странах. В нашей стране новейшая модель «Феликс» производилась миллионными тиражами и продавалась года примерно до 1980-го. А вот любопытный экспонат петербургского Музея связи - счетно-суммирующая машина СДУ-138, датируемая серединой XX века. По большому счету, тот же арифмометр:

Среди арифмометров были немногочисленные «умные» образцы, но большинство было попроще: они могли выполнять только сложение и вычитание.

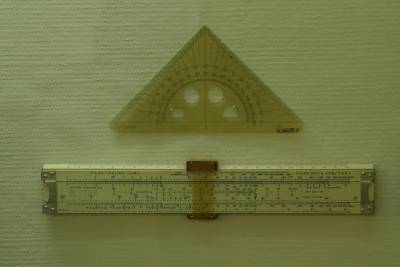

В XVII веке была изобретена логарифмическая линейка - прибор, позволявший выполнять поначалу только умножение и деление, а чуть позже «научившийся» и многим другим действиям. У меня хранится логарифмическая линейка, на которой еще отец считал студенческие курсовики, и я ею даже изредка пользуюсь. Это обычная прямая линейка, а у отца была еще круглая, похожая на карманные часы - довольно редкий экземпляр даже для своего времени, но она у нас не сохранилась.

Логарифмическая линейка подкупает простотой устройства, карманной переносимостью и мгновенной готовностью к действию. Это прибор универсальный, но на этом же принципе позже были созданы специализированные приборы. На следующем фото - экспонат музея «Золотые ворота» во Владимире - авиационная штурманская линейка времен Великой Отечественной войны:

В 1846 г. петербургский учитель музыки Куммер изобрел счислитель, названный впоследствии по фамилии автора. Счислитель Куммера представлял собой плоскую коробку величиной со школьный пенал, внутри которой имелись подвижные планки с нанесенными на них цифрами. В какой-то мере счислитель Куммера был родственником арифмометров, отличаясь от них тем, что вместо колес в нем были прямые планки. Такие приборы выпускались до второй половины XX века.

Арифмометр, как и счетные линейки, как и более современная машина - электронный калькулятор (изобретенный в 1971 г.), может производить одиночные арифметические действия по команде человека. Чтобы устройство могло претендовать на название «компьютер», оно должно обладать способностью автоматически выполнять последовательность действий (арифметических или иных), обеспечивающую решение некоторой задачи: одной (специализированный компьютер) или многих (универсальный компьютер).

В 80-е годы XIX века американец Г. Холлерит (в старых книгах может встретиться написание фамилии Голлерит) изобрел табулятор. По большому счету это шкаф с множеством счетчиков (первоначально 40, у следующих образцов могло быть по-разному), каждый из которых может увеличивать свое значение на единицу при замыкании электрической цепи. Носителем информации для табулятора служили картонные перфокарты наподобие тех, которые раньше использовались в жаккардовых ткацких станках. Перфокарта была разделена на позиции (числом таким же, как число счетчиков в табуляторе), и в каждой позиции можно было пробить отверстие. Когда перфокарта вводилась в табулятор, каждый из его счетчиков либо сохранял прежнее значение, либо плюсовал единицу, если соответствующее отверстие пробито.

Для чего была нужна такая машина? Табулятор был впервые применен в 1890-м году для обработки результатов переписи населения США. Сведения о каждом жителе страны записывались на перфокарту путем пробивки отверстий в нужных позициях перфокарты. Например для сведений об образовании могли отвести 4 позиции: «неграмотный», «начальное», «среднее» или «высшее». По завершении переписи все перфокарты были пропущены через табулятор, и каждый из счетчиков показал количество перфокарт, в которых имелось отверстие в соответствующей позиции, т. е. можно было увидеть прямо в цифрах, сколько в стране людей неграмотных, сколько с начальным образованием и т. д. В последующие десятилетия табулятор был усовершенствован, «научился» новым действиям. Подобные устройства выпускались до середины XX века, а в 1986 году на студенческой практике мне довелось видеть немецкий трофейный табулятор постройки, кажется, 1937 года: он стоял рядом с ЭВМ «Минск-32» и находился в повседневной эксплуатации!

Именно табуляторы были первой продукцией знаменитой американской фирмы IBM. Это были громоздкие, тяжелые (почти в тонну весом) агрегаты из нескольких тысяч деталей. При работе они издавали шум, напоминающий пулеметную стрельбу.

Табулятор представляет собой просто набор счетчиков, хотя и собранных в общем корпусе, но действующих по отдельности и выполняющих одну простейшую операцию: увеличение на 1. Компьютером такая машина считаться не может.

Вам, вероятно, знакомо слово тотализатор? В представлении советского/российского человека, читавшего романы английского писателя Дика Френсиса, это слово прочно ассоциируется с преступными играми на ипподроме. С играми, ради которых людей порой убивают… Но давайте попробуем разобраться беспристрастно, что представляет собой тотализатор с чисто технической точки зрения. А представляет он не что иное как машину, выполняющую операцию тотализации, т. е. подведения постатейных подытогов. Это гибрид табулятора и арифмометра, или несколько арифмометров в одном: каждый из них, кроме одного, суммирует вводимые в него числа, а один счетчик - последний - суммирует все, что введено в прибор. То есть мы для множества чисел (ставок разных игроков на разных лошадей) подсчитываем постатейные подытоги (ставку на каждую лошадь) и общий итог. Когда все ставки приняты, владелец тотализатора сопоставляет полученные итоги и вычисляет процент выигрыша, приходящийся на каждую ставку. Машина подобного типа существовала и вне ипподрома, называлась она счетно-аналитической машиной и использовалась в бухгалтерии для решения задачи аналитического учета (то, что у бухгалтеров называется аналитическим учетом, как раз типичная задача тотализации). В СССР первые такие машины (импортные) появились в 1925 г. А десятью годами позже в Москве был открыт Первый государственный завод счетно-аналитических машин. На нем с 1939 г. под маркой «Т-4» выпускались сальдирующие табуляторы конструкции В. Н. Рязанкина, способные не только складывать, но и вычитать (термины «табулятор» и «счетно-аналитическая машина» тогда уже стали практически синонимами). И еще один родственник табулятора и тотализатора - механический кассовый аппарат, предложенный в 1875 г. Такой аппарат, как на следующем фото слева (КИМ-3-СП), можно было увидеть в любом магазине на протяжении большей части XX века, а теперь - только в Музее связи. Правда, этот аппарат более поздний (1978 г.), но конструктивно он мало отличается от аппаратов конца XIX - начала XX в. Справа - кассовый аппарат «Онега-III» (1969 г.), предназначенный для использования на почте.

В нашей стране подобные кассовые аппараты использовались примерно до 90-х годов ХХ века, пока не были заменены электронными.

Табуляторы и арифмометры представляют собой цифровые устройства: каждая величина («переменная»), используемая при вычислении, имеет конечный ряд допустимых значений и не может принимать значения в промежутках между соседними значениями из ряда. В отличие от них логарифмическая линейка - устройство аналоговое: хотя на ней и нанесены деления, каждая переменная может принимать непрерывное множество значений от нуля до максимума.

Принципиально важно: любое цифровое устройство со времен Паскаля и Лейбница до наших дней и до неопределенно далекого будущего выполняет операции над большими числами ПОРАЗРЯДНО. Это обеспечивает абсолютно точный результат сложения, вычитания и умножения, а при всех других математических операциях позволяет получить результат с любым наперед заданным количеством верных цифр. Аналоговое устройство всегда дает результат с погрешностью.

Табулятор, арифмометр, тотализатор и кассовый аппарат - машины близкородственные, и для них вводится собирательный термин: протокомпьютеры (предки компьютеров). Эти машины выполняли лишь простейшие однообразные арифметические действия. Протокомпьютер может сложить хоть тысячу, хоть миллион показателей миллиардной величины каждый и не ошибиться при этом ни на копейку. Совсем даже неплохо, если вспомнить, какой процент населения в те годы имел начальное образование, допустим, в тех же США или в Российской империи! Но задачи эти соответствовали начальным классам школы. Задачи хотя бы на уровне 6-7 классов школы - со степенями и корнями, не говоря уж про логарифмы и тригонометрию, этим машинам были категорически не по зубам. Так что при научных и инженерных расчетах протокомпьютеры были слабым подспорьем, и использовались там, где их способности были достаточны: в статистике, бухгалтерии и в смежных отраслях. Хотя табуляторы и механические кассовые аппараты и дожили до конца средних веков (до 80-х годов XX века), эпоха протокомпьютеров продолжалась до 1910-х годов - для этой эпохи предлагается термин компьютерный мезолит.

В 20-е-50-е годы XIX века над созданием счетных машин работал английский математик Ч. Бэббидж. Он поставил амбициозную задачу построить «аналитическую машину» (не путать с машинами Холлерита и Рязанкина), которая могла бы выполнять арифметические действия по программе. Он только еще приступил к изготовлению деталей для машины, а его помощница (и вероятно единственная единомышленница) Ада Лавлейс уже составила для этой машины первую программу. Рассказ об этой программе кочует из книги в книгу, но… саму эту программу никто не видел, на каком языке она была написана - никто не знает (зато все знают, что Бэббидж никаких языков не создавал), работоспособность этой программы ничем не доказана…

Машина Бэббиджа явно опережала свое время. В эпоху, когда еще в помине не было никакой электротехники, механическая вычислительная машина должна была стать сложнейшим техническим изделием из всех, какие только могло вообразить человечество! На порядок сложнее любых пароходов и железных дорог! Построить такое чудо своими силами нечего было и думать. Время от времени Бэббиджу удавалось выбить какое-то финансирование из бюджета, но его вечно не хватало. Да и не очень-то охотно ему давали, зная его непостоянный характер. Он занимался разными науками, начинал и бросал, и опять начинал и опять бросал… Прожил долгую, полную событий жизнь и так и не увидел своего детища в работе. Непохоже, чтобы его это сильно угнетало. Он предвидел, что его наработки пригодятся лет через 50. В действительности же его научное наследие оказалось по-настоящему востребовано только на рубеже 30-х-40-х годов XX века: в 1938-1941 годах немец К. Цузе построил машины Z1, Z2 и Z3, используя теоретические наработки Бэббиджа и Буля (о котором чуть ниже), но на новой конструктивно-технологической базе с использованием электромагнитных реле. Если уж ставить вопрос о первом компьютере, то машины Цузе как раз и претендуют на это звание. Несколькими годами позже в США построен компьютер «Марк I», при проектировании которого также использовано наследие Бэббиджа.

Еще один персонаж, которого мы не должны забыть, - английский математик Джордж Буль. Никаких вычислительных устройств он не строил - он был чистым теоретиком. В 1847-1848 годах он опубликовал несколько научных трудов по логике, на основании которых сформировалось учение, названное в его честь: булева алгебра. В свое время булева алгебра осталась недооцененной, но через 100 лет, когда потребовались теоретические основы создания современных компьютеров, о ней вспомнили, а уж как вспомнили, так больше не забывали: современный компьютерный мир без нее немыслим, об ее пересмотре даже вопрос не ставится.

***

Если забить в Яндекс «последний советский паровоз», то вам хватит минуты, чтобы выяснить: это был П36-0251 (Коломенский завод, 1956 г.). Кстати сейчас этот паровоз находится в музее в Санкт-Петербурге, а в России немало таких паровозов имеется в разном состоянии, вплоть до полностью работоспособного. Информация, как видим, абсолютно ясная и исчерпывающая. Если же возвратиться к нашей теме, то здесь подобной ясности не будет и в помине. Когда и где был построен последний в мире (или в СССР) табулятор? Готового ответа нет, но сколько бы мы его ни искали, мы не будем иметь гарантии, что этот ответ окончательный.

Военные вычислительные устройства первой половины XX века

На первых русских линкорах, проектировавшихся около 1910-го года, впервые в нашей истории был внедрен принцип центрального управления стрельбой орудий главного калибра. Вообще-то приборы управления стрельбой были предложены петербургским часовым мастером Н. Гейслером еще в 90-е годы XIX века (фирма Гейслера строила также телеграфные аппараты). Комплекс Гейслера включал задающие приборы, установленные в боевой рубке, и принимающие приборы, расположенные непосредственно у орудий и соединенные проводами с задающими приборами. Органами отображения информации служили циферблаты со стрелками - ничего другого в те времена не было. Задача наводчика сводилась к тому, чтобы развернуть орудия до совмещения со стрелками выходных данных прибора. Сами же приборы по существу представляли собой сельсины. https://ru.wikipedia.org/wiki/%D0%A1%D0%B5%D0%BB%D1%8C%D1%81%D0%B8%D0%BD

Такая система только передавала данные от командира к орудиям и не содержала каких-либо счетно-решающих элементов. По итогам русско-японской войны стало ясно, что система требует усовершенствования. В Англии были закуплены счетно-решающие приборы конструкции А. Поллена, но что эти приборы собой представляли? Информация крайне скудная. Можно не сомневаться, что устройством ввода данных в этот прибор служил оптический дальномер, установленный на корабле в соответствующей надстройке. А что внутри прибора? Можно только догадываться.

Представим себе валик, закрепленный в подшипниках с возможностью поворота вокруг своей оси. Если валик не трогать, то он сохраняет угол поворота, т. е. представляет собой запоминающую ячейку, имитирующую некоторую величину, участвующую в расчетах. Эту величину можно сразу же отображать визуально, если снабдить валик стрелкой и шкалой. Если валик поворачивать с некоторой скоростью, то его угловое положение будет представлять интеграл скорости, и получаем простейший вычислительный элемент - интегратор. Представим, что на валик насажено колесико, но не круглое, а имеющее какую-то криволинейную форму, и к краю колесика прижимается рычаг. Угловое положение этого рычага однозначно связано с угловым положением вала, но связано не непосредственно, а по какой-то зависимости (возможно сложной), определяемой формой колесика - и получаем вычислительный элемент - функциональный преобразователь. Два валика, соединенные системой рычагов, представляют сумматор…

Несколькими годами раньше российский инженер Алексей Крылов изобрел дифференциальный интегратор - механическую вычислительную машину, также основанную на валиках, колесиках и рычажках и решающую дифференциальные уравнения (применялась при проектировании кораблей).

Примерно в то же самое время был построен эскадренный миноносец «Новик» - быстрейший корабль своего времени. Его главным оружием были не пушки, а торпеды, и для стрельбы ими был построен прибор центрального управления. Информации по этому прибору еще меньше. «Новик» был построен в единственном экземпляре, но почти сразу же было начато серийное строительство эсминцев, достаточно близких к нему. На них устанавливался торпедный прицел М-1 конструкции Михайлова, однако сейчас уже трудно понять, что он собой представлял: прибор управления или просто прицел. А на эсминцах последующих серий устанавливались приборы управления торпедной стрельбой (ПУТС), созданные петербургским филиалом шведской фирмы «Эриксон». Они оказались недостаточно надежны и к 1932 г. были заменены приборами ГАК-1, которые выпускались заводом «Электроприбор» N 212.

В 30-е-40-е годы двадцатого века строились эскадренные миноносцы проекта 7 и 7У - внуки «Новика». На них уже было три прибора управления стрельбой: для орудий главного калибра, для зенитных орудий и для торпед. На кораблях более поздней постройки - лидерах - ставились ПУТС итальянской фирмы «Галилео». Закупка приборов передового технического уровня за рубежом, с одной стороны, не дает отечественным ученым и инженерам расслабляться, а с другой стороны, обогащает их ценным опытом. Так что в целом это нормальная практика, только ею не следует злоупотреблять. И уж совершенно недопустимо навязывать инженерам бездумное «передирание» иностранных образцов вместо создания своих, более совершенных. На лидерах «Минск» и «Ленинград» уже во время Великой Отечественной войны ПУТС «Галилео» были заменены на отечественные «Мина-1», созданные тем же заводом «Электроприбор» еще в 1934 г.

Подробнее смотрите вот здесь: http://naukarus.com/iz-istorii-sozdaniya-priborov-upravleniya-torpednoy-strelboy-v-otechestvennom-flote

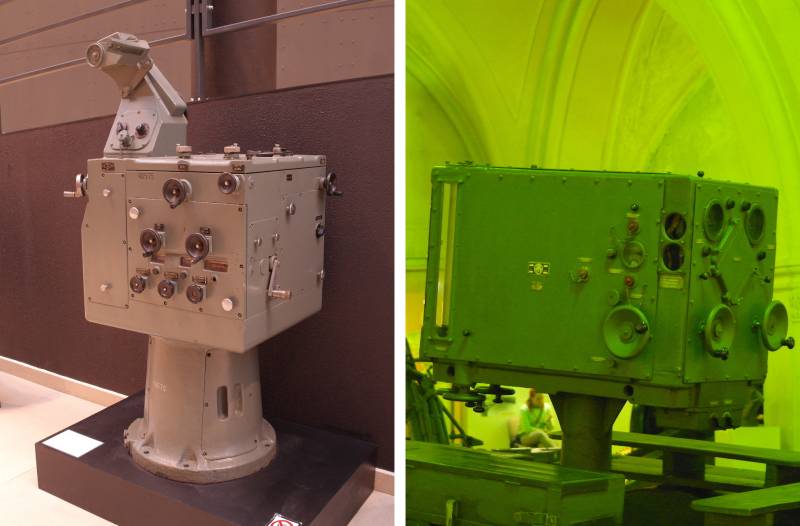

Прибор управления артиллерийским зенитным огнем (ПУАЗО) можно увидеть как в Артиллерийском музее, так и в Военно-морском, но эти экспонаты дают представление только о внешнем виде прибора:

А что там внутри? Развинчивать музейный экспонат нам, конечно, не позволят. Однако давайте сделаем небольшое умственное упражнение: прикинем, какой прибор сложнее - для стрельбы по кораблям или по самолетам?

Бой «корабль против корабля» идет в плоскости. Для нашего корабля нам нужны двумерные координаты X1 и Y1, скорость V1 и курс K1, для противника - аналогичный набор параметров X2, Y2, V2, K2. Если же мы ведем бой «корабль против самолета», то нам никуда не деться от использования всех тех же самых переменных, но нам потребуется еще одна координата - высота самолета, которую к тому же нужно как-то вычислить. Кроме того, поскольку скорость самолета гораздо больше скорости корабля, наш прибор должен обладать достаточным быстродействием, иначе его показания не будут успевать за реальной обстановкой. Очевидно, что ПУАЗО будет сложнее, чем прибор для стрельбы по кораблям.

Задача наведения торпеды гораздо проще: торпеда движется прямолинейно и равномерно, строго по горизонту, для нее не существует недолета или перелета. Чтобы попасть в цель, торпеде нужен единственный параметр - курс. Вычисление его - геометрическая задача для 7-8 классов школы. Поэтому самолетные и катерные торпедные прицелы не представляют собой ничего сложного. Совсем другое дело на подводной лодке. Лодочный прибор управления торпедной стрельбой (автомат торпедной стрельбы, в англоязычной литературе часто называемый торпедным директором) будет еще сложнее, чем корабельные артиллерийские приборы. В годы Второй мировой войны такие приборы весьма высокого технического уровня имелись в Германии и в США http://brummel.borda.ru/?1-10-0-00000030-000-0-0-1163166714. Чуть послабее - в Англии. А что у нас? Похоже, что ничего. Как такое может быть?

Очень хотелось бы изучать вычислительную технику, не отвлекаясь на пресловутую политоту. По возможности я буду действовать именно так, но это не наш сегодняшний случай. Если мы хотим понять, как развивалась советская вычислительная техника в 30-е-40-е годы XX века и, главное, ПОЧЕМУ она развивалась именно так, то придется вспоминать, в каком мире живем. После прихода Гитлера к власти в Германии (1933 г.) призрак войны уже не бродил по Европе - он по ней маршировал! А в СССР война уже шла - страшная война на уничтожение собственного народа. Только не говорите, что ничего такого не было. И инженеры, и ученые, и те, кто ими командовал, находились в очень двойственном положении. С одной стороны, «если завтра война, если завтра в поход», то войну не выиграть одной лишь трехлинейной винтовкой на брезентовом ремне: чтобы победить врагов на войне, нужно современное, высокотехнологичное оружие. Это вроде бы понимали все. С другой стороны, любая чисто инженерная идея могла кому-нибудь показаться антипартийной или вредительской. А могла не показаться - могла быть умышленно объявлена таковой. И тогда ее автору не сносить головы. Выходит, что успех того или иного инженерного проекта зависел от физического выживания его руководителя. Тем, кто создавал приборы для надводных кораблей, повезло чуть больше. Тем, кто создавал приборы для подводных лодок - чуть меньше. Во время войны за это «невезение» наши моряки заплатили страшную цену.

Так это было или не так, но факт, что конструирование ПУТС «Трап» было начато с запозданием. До

начала войны приступить к серийному выпуску приборов не успели, и только во второй половине 1944 г. первые приборы этого типа поступили на вооружение, так что в реальных боях им уже не довелось участвовать. Лишь на немногих наших лодках в годы войны имелись английские ПУТС. На следующем снимке - автомат торпедной стрельбы на подводной лодке С-189, которая сейчас стоит в качестве музея в Санкт-Петербурге, но это прибор более поздний, послевоенный.

Могут ли эти приборы считаться компьютерами?

Американский моряк-подводник Дж. Инрайт в своей книге «Синано: потопление японского секретного суперавианосца» рассказывает об имевшемся на его лодке приборе управления торпедной стрельбой, и этот прибор он недвусмысленно называет компьютером. Но ведь Инрайт - моряк, а не специалист по вычислительной технике. Можем ли мы согласиться с его трактовкой? На этот вопрос мы опять-таки не сможем ответить, пока не определимся, что считать компьютером, а что нет.

Чтобы прибор мог считаться компьютером, он должен обладать, как минимум, одной из двух способностей: (а) выполнять не одну какую-то математическую операцию, как например арифмометр, а расчеты с множеством действий, когда результат какого-то действия используется в последующих действиях, т. е. реализовать алгоритм, и (б) решать задачу многократно для изменяющихся исходных данных. Прибор, о котором пишет Инрайт, обоим этим требованиям удовлетворяет…

Еще один аргумент «ЗА»: состояние устройств вывода описанных выше приборов неоднозначно зависит от входных данных на текущий момент: оно зависит также и от того, что было на входе раньше. Иными словами, эти приборы обладают памятью. Однако есть и аргумент «ПРОТИВ»: алгоритм, реализованный в этих приборах, целиком определяется их конструкцией и не может быть изменен, т. е. такие приборы не программируются.

Рассматривая приборы управления стрельбой первой половины и середины XX века, любой нормальный ученый-историк на этом поставил бы точку. Я ставлю не точку, а запятую. Прибор центральной наводки орудий выдавал на свой выход углы наводки по вертикали и горизонтали - во времена Первой мировой войны ни о чем другом думать не приходилось. На самом деле вычислить углы наводки - половина дела. Вторая половина дела состоит в том, чтобы развернуть многотонное орудие на нужные углы быстро и точно (от быстроты и точности зависит победа в бою!). Для решения этой задачи в середине XX века была разработана специальная физико-математическая дисциплина: теория следящих систем, или теория автоматического регулирования. Решающий вклад в эту науку внесли ученые из Великобритании. Когда же теория была создана, очевидно, не заставил себя ждать и прибор, основанный на этой теории, - пропорционально-интегрально-дифференциальный регулятор (ПИД-регулятор). Без ПИД-регуляторов немыслима современная промышленная автоматика (да и военная тоже). Принципиально важно: такой регулятор НЕ МОГ появиться раньше, чем была разработана теория. В нынешних учебных заведениях изучается принцип устройства и действия таких регуляторов (современных!), но ни в какой литературе мне не встречалось ни малейшее упоминание о том, где и когда такие приборы впервые использовались, как выглядели, кем строились… И уж подавно ни один историк военного кораблестроения ни слова не скажет о том, что корабль, оснащенный ПИД-регуляторами, имеет все шансы на победу в бою над противником, не имеющим таких регуляторов.

Я пишу о морских вычислительных приборах, поскольку с ними хоть как-то знаком. Свои вычислительные средства были и в авиации: штурманские приборы, бомбовые и стрелково-пушечные прицелы… Так получилось, что до середины XX века военная вычислительная техника развивалась бурно, а гражданская заметно от нее отставала.

***

Обычный ученый-историк предпочитает изучать письменные документы: они дают точное представление о датах и участниках событий. Если же письменных источников не хватает, прибегают к археологическим методам исследований: ищут и описывают вещественные следы исчезнувших цивилизаций. Сведения, которые дает археология, чаще всего приблизительны и вероятностны, но лучше так, чем совсем никак. И вот сейчас мы подходим к такой ситуации, что от приборов, которым всего-то лет 50 или чуть больше, не осталось никаких следов. Ни одного сохранившегося экземпляра, ни чертежей, ни эксплуатационной документации… Археологам легче найти золотое украшение двухтысячелетней давности, чем железку, которой пользовались наши отцы! Впрочем, найти железку - половина дела. Как минимум, находку нужно описать, но кто сможет это сделать? Как хотя бы называется инженерная специальность, носитель которой мог бы спроектировать автомат торпедной стрельбы? Представьте, что перед нами прибор из тысячи деталей, действующих на основании науки, которая уже много лет не преподается ни в каких учебных заведениях… А если уж мы говорим о приборах военного назначения, то хорошо бы описать приборы так, чтобы можно было разобраться, какой из них на войне более победителен. Авторы даже самых толковых книг по истории военных самолетов, кораблей, танков не любят писать о приборах: они сами недостаточно хорошо ориентируются в этих вопросах и того же ожидают от своих читателей.

В завершение темы: пост системы управления огнем 127-мм артиллерии американского авианосца «Хорнет», погибшего в ходе Второй мировой войны, на дне Тихого океана на глубине свыше 5 км:

https://pp.userapi.com/c845018/v845018292/1ab1bc/A8qGbo7tVqI.jpg

Вот так мы с вами прямо сейчас стоим у истоков новой науки - технологической археологии.

Водяные компьютеры

В 1936 году В. С. Лукьянов, основываясь на опыте уже упоминавшегося нами Крылова, создал гидравлический интегратор - специализированное устройство, решающее задачу интегрирования. Интегрирование (лат. накопление, объединение) - в простейшем случае нахождение интеграла от некоторой функции (чаще всего меняющейся от времени) - эта задача изучается в старших классах школы, но этим же термином называются и более сложные (университетского уровня) задачи - решение дифференциальных уравнений. В качестве рабочей субстанции в машине Лукьянова использовалась вода. Она двигалась по стеклянным трубкам, наполняла сосуды, так что весь процесс решения задачи можно было наблюдать зрительно. В течение без малого двух десятилетий Лукьянов работал над усовершенствованием своих интеграторов, каждая следующая модель была сложнее предыдущей и соответственно могла решать более сложные задачи. Использовались эти устройства чуть ли не до 1980-х годов. Сейчас два лукьяновских интегратора хранятся в Политехническом музее в Москве.

Иногда считают, что Лукьянов был единственным автором вычислительных устройств, использующих воду, но это не так: в 1949 году У. Филлипс в Новой Зеландии в гаражных условиях, из подручных материалов, вплоть до обломков старых самолетов, построил водяной компьютер MONIAC. Это было едва ли не первое вычислительное устройство, построенное как учебно-демонстрационное пособие специально для моделирования экономических процессов. MONIAC неплохо себя проявил, после чего было построено несколько серийных образцов, один из которых работоспособен до сих пор. Он находится в Кембриджском университете и ежегодно демонстрируется студентам.

https://ru.wikipedia.org/wiki/MONIAC

Описанные в этой и в предыдущей главах вычислительные устройства назовем собирательным термином эокомпьютеры («компьютеры рассвета»). От протокомпьютеров они отличаются тем, что могут решать задачи во много действий, т. е. выполнять алгоритм, да и действия, доступные им, выходят за рамки младшей школы: криволинейные функциональные преобразования (в том числе тригонометрия) - это старшие классы школы, а интегрирование - это уже высшая математика. До настоящих компьютеров им не хватает одного единственного пунктика: программирования. Программировалась они только конструктивно, т. е. программа встраивалась в прибор намертво и ее невозможно было сменить без коренной переделки аппаратуры. Эпоха промышленного выпуска эокомпьютеров, или компьютерный неолит, начинается в промежутке между русско-японской и Первой мировой войнами, т. е. где-то около 1910 года, и продолжается примерно до 1950-го года, когда на смену эокомпьютерам пришли настоящие компьютеры.

Криптография и криптоанализ как движущая сила компьютеростроения

Вы, вероятно, слышали про немецкую шифровальную машину «Энигма»? Может быть, видели один из фильмов с таким названием? Кстати, похожие машины были и у нас:

https://www.kv.by/content/335378-shifrovalnye-mashiny-kakie-analogi-enigma-sozdavali-v-sssr

https://web.archive.org/web/20131219014556/http://www.agentura.ru/press/about/jointprojects/inside-zi/sovietcryptoservice/

и у наших союзников по антигитлеровской коалиции («Тайпекс», Англия, 1937 г.), но, благодаря отсутствию установленных фактов «взлома» шифра противником, наши машины остались практически неизвестны широкой публике, а история раскрытия поляками, англичанами и американцами шифра «Энигмы» сделала этой машине большой посмертный пиар.

Сейчас я хочу немножко абстрагироваться от конкретных машин, взглянуть на ситуацию со следующего уровня высоты полета. В начале XX века, с развитием электрической связи и радиотехники, остро встала задача передавать сообщения так, чтобы они не стали известны противнику. Сам принцип радиосвязи не оставляет надежд на то, что ваши радиограммы не будут прослушаны. Остается единственный вариант: шифроваться (а для супостата единственный вариант - пытаться «расколоть» наши шифры). Криптография и криптоанализ - строгие математические дисциплины, но поскольку речь идет о победе государства в войне, то математика стала оружием. Оружием совершенно специфическим: взяв его в руки, горстка кабинетных храбрецов без гранат, без пушек останавливает танковые дивизии! Ничего удивительного, что подобные математические исследования неплохо финансировались. Еще в 20-е годы немалых успехов на этом поприще добилось польское «Бюро шифров». Потренировавшись на совсем слабых в то время советских шифрах, они поставили планку выше: решили расколоть «Энигму», и они это сделали.

Математическая криптография первой половины XX века шла по пути наименьшего сопротивления: создавала шифрсистемы с закрытым ключом. Смысл в том, что алгоритм шифрования либо вообще открытый, либо существует вероятность, что он станет известен врагу. Но для расшифровки наших посланий алгоритм знать недостаточно: нужен ключ, который известен только отправителю и получателю. Два субъекта, желающие установить связь друг с другом, предварительно должны обменяться ключами, и сделать это нужно так, чтобы ключ не попал в чужие руки. Пока субъектами были военные и государственные учреждения, такой подход всех устраивал. Но история имеет свойство повторяться. В начале XXI века задача установления засекреченной связи стояла уже перед простыми гражданами, для которых обмен закрытыми ключами был сопряжен с определенными трудностями, а то и вовсе невозможен. Ответом на эту задачу стали шифрсистемы с открытым ключом, но это уже совсем другая история.

Можно ли считать «Энигму» компьютером? По-моему, нет. В лучшем случае она тянет на специализированный гаждет. Зато машина «Бомба», которую англичане построили для раскрытия шифра «Энигмы», к компьютерам приближается вплотную. Когда же вместо «Энигмы» немцы построили более хитрую машину «Лоренц», англичане ответили им своим «Колоссусом» (1943 г.). В создании «Бомбы» участвовал математик Алан Тьюринг. «Бомба» была специализированным устройством, но, работая над ней, Тьюринг уже задумывался о том, что делать дальше, и выдвинул принципы построения универсальных машин: (1) машина должна иметь множество одинаковых запоминающих ячеек, (2) любая математическая операция может быть выполнена с данными из любых ячеек, (3) чтобы указать машине, какие операции нужно выполнять и над какими данными, пишется программа, которая не «ввинчивается» в машину намертво, а помещается опять-таки в запоминающие ячейки, где она может быть быстро и легко заменена без ущерба для «железа». Идейное наследие Тьюринга этим отнюдь не исчерпывается. В учебниках рассматривается машина Тьюринга - это математическая абстракция, которая никогда не воплощалась в металле и никогда не будет воплощаться, потому что менее эффективна, чем обычные компьютеры.

Как мы теперь видим, Тьюринг был не первый, кто додумался до теоретических принципов построения компьютера (за исключением того, что в машинах Цузе программа не хранилась в запоминающих ячейках, а читалась с перфоленты). Тьюринг был первым, кто заявил эти принципы вслух, и первым, кого услышали, в итоге получилось так, что он считается основоположником современной архитектуры компьютеров. В рамках принципов, выдвинутых Тьюрингом, были построены машины: в Англии - EDSAC (1949 г.), в США - ENIAC (1944 г.) и EDVAC (1949 г.), которые уже без всякой натяжки могут считаться настоящими компьютерами. Эти машины знаменуют собой конец первобытной эпохи и начало компьютерной цивилизации.

Характеристика эпохи

Первобытная эпоха в компьютерном мире продолжалась до середины XX века и характеризовалась следующим:

* Половина объема вычислений, производимых во всем мире с применением технических средств, приходилась на механические и электромеханические вычислительные устройства, выполняющие только одиночные или однообразно повторяющиеся операции под непрерывным управлением человека, а другая половина - на специализированные приборы, значительная часть которых работала по аналоговому принципу и не обеспечивала возможности сменить программу. Появление программируемых цифровых компьютеров ознаменовало собой первую смену исторических эпох (не путать с поколениями ЭВМ).

* Предлагаемый здесь термин «первобытная эпоха» отражает то обстоятельство, что в эту эпоху не существовало ни общей теории построения вычислительных машин, ни каких-либо единых стандартов их конструирования: каждый автор создавал свое детище с нуля, был вынужден вычерчивать отдельно каждую деталь. Все это сильно замедляло работу.

* Хотя к концу эпохи уже налаживалось серийное производство вычислительных устройств на заводах, основной движущей силой прогресса были одиночные гении-изобретатели, многие из которых остались непонятыми и непризнанными. Что же касается программирования, то его по сути не было, если не считать той самой первой программы, которую якобы составила Ада Лавлейс.

50-е-60-е годы ХХ века - эпоха древней компьютерной цивилизации

В годы Второй мировой войны и после нее наметился коренной пересмотр взглядов человечества на вычислительную технику. Развивалось кораблестроение, авиация, ракетная техника, энергетика (в т. ч. атомная). На повестке дня стояло освоение космоса. Стало ясно, что современные технические изделия невозможно создавать, полагаясь только на интуицию мастеров - нужны подробные и точные расчеты. Произошло именно то, о чем мы говорили в предыдущей главе: людям нужно было очень много считать, и это невозможно было делать бесплатно. Кто имел хороший компьютер, тот имел наше все, а кто компьютера не имел, был обречен оставаться лузером - не важно, просто человек, или завод, или целое государство. Но кто мог построить хороший компьютер? Стало ясно, что время энтузиастов прошло и к делу пора подключать бюджет.

Советские цифровые ЭВМ 1950-х-1960-х годов

В нашей стране из-за потерь, причиненных войной, работы по созданию новой техники замедлились. Работа над малой электронно-счетной машиной - МЭСМ - была начата в конце 1948 года в Киевском институте электротехники АН УССР, а чуть позже в Энергетическом институте АН СССР (Москва) - над машиной М-1. В регулярную эксплуатацию обе машины были приняты почти одновременно - в декабре 1951 года. Так наши инженеры вступили в мировую «компьютерную гонку», в которой очень скоро достигли впечатляющих результатов. Нам не нужно было догонять Америку - Америка догоняла нас.

Оба проекта оказались успешными и получили дальнейшее развитие.

Семейство быстродействующих электронно-счетных машин - БЭСМ - было наследником МЭСМ и разрабатывалось Институтом точной механики и вычислительной техники АН СССР (ИТМ и ВТ, Москва) с 1953 г. Новейшая машина этого семейства - БЭСМ-6 - первой преодолела рубеж быстродействия 1 миллион операций в секунду и в первые годы своего существования (1968-1970) была быстрейшей в мире. Однако первой серийной машиной стала «Стрела» с быстродействием всего 2000 операций в секунду. Она спроектирована ЦКБ-245 в Москве и выпускалась в 1953-1956 г. (выпущено всего 8 штук, но МЭСМ и первые БЭСМ существовали в единственном экземпляре и, таким образом, должны считаться экспериментальными).

БЭСМ-6 не создавалась для рекордных гонок - это была обычная серийная машина, было изготовлено свыше 300 штук (выпускались до 1987 г., а последняя из них действовала на вертолетном заводе им. Миля до 1995 г.).

http://besm-6.ru/besm6.html

На основе М-1 разрабатывались машины М-2, М-3 и т. д. Документация на М-3 была передана в Ереванский научно-исследовательский институт математических машин (ЕрНИИММ), где на ее основе создавались ламповые ЭВМ «Арагац» и полупроводниковые - «Раздан» (1958-1965 гг.). Следующей вехой на пути ереванцев стала «Наири» (1962 г.). Это была простенькая машинка, на рекорды скорости она на первый взгляд не претендовала - рекорд был в другом. Если все предшествующие ЭВМ имели вид множества шкафов, занимающих большую комнату (скорее зал), то «Наири» была выполнена в виде письменного стола с двумя тумбами. Она занимала всего несколько квадратных метров в помещении, что соответствовало обычному рабочему месту инженера или ученого, и обслуживалась одним человеком… Это что же получается, первый в мире персональный компьютер?

Перед нами обложка технического описания ЭВМ «Наири» (описание, кстати, доступно в интернете). Рисунок дает представление о внешнем виде машины:

«Наири-3», созданная уже в 70-е годы, была построена на микросхемах эмиттерно-связной логики и считается первой оригинальной отечественной машиной третьего поколения (о поколениях ЭВМ, в традиционном понимании этого термина, поговорим чуть ниже).

Эстафету разработки советских персональных компьютеров подхватили в Киеве, в Институте кибернетики Академии наук УССР. Там еще в 1958 г. была начата разработка машин семейства «Проминь» (серийное производство с 1963 г.). Эта ЭВМ впервые в отечественной практике позволяла ввод данных с клавиатуры и вывод на однострочный индикатор, как в нынешних калькуляторах (по большому счету эта машина и была первым программируемым калькулятором). Следующим этапом стала МИР - Машина Инженерных Расчетов (1965 г.). На ней был реализован командный язык высокого уровня Алмир (АЛгоритмический язык для МИР), позволявший производить сложные математические и физические расчеты с минимумом трудозатрат на программирование. В этой машине были воплощены новые для того времени технические решения (некоторые из них были впоследствии забыты), позволявшие решать сложные численно-расчетные задачи практически с такой же скоростью, как на гораздо более мощных машинах. По сути, МИР и язык Алмир стали бабушкой и дедушкой нынешнего «Матлаба».

В городе Пенза на предприятии п/я 24 проектировались с 1955 г., а на заводе счетно-аналитических машин строились до 1975 г. ЭВМ семейства «Урал». Первые 4 машины были ламповыми, последующие - полупроводниковыми. Они интересны тем, что представляли именно семейство машин, программно совместимых между собой.

В Минске в конце 1950-х годов были одновременно построены Конструкторское бюро НИИЭВМ (СКБ) и завод ЭВМ им. Орджоникидзе. Создававшиеся там машины вполне логично получили название «Минск». Первая машина «Минск-1» (1959 г.) была построена на лампах, «Минск-2» и ее модификации - на полупроводниковых потенциально-импульсных логических элементах. «Минск-32» стала самой массовой отечественной ЭВМ (1968-1975 гг., выпущено 2889 шт.).

Там же, в Минске, в 1959-1964 гг. разрабатывались и выпускались примерно до 1972 г. ЭВМ «Весна» и «Снег» (последний представлял собой упрощенную «Весну»), но они выпускались малыми сериями (всего 19 и 20 шт. соответственно).

В 1958 г. в вычислительном центре N1 МО СССР была создана ЭВМ М-100, которая стала «Новиком» среди компьютеров - одной из быстрейших в мире для своего времени (100 тыс. операций в секунду), и навсегда осталась таковой среди ламповых ЭВМ. В этой машине, а отнюдь не в американском «Пентиуме» 1990-х годов, впервые были воплощены такие технические решения, как конвейерное выполнение операций, кэш-память («сверхоперативная память» по терминологии того времени) и оперативная память на кольцевых ферритовых сердечниках.

Мы пробежались «галопом по европам» по основным мозговым центрам союзкомпьютерпрома, упомянули те машины, которые имели словесные названия. Кроме них, было еще много машин, называвшихся буквой М с числовыми индексами, а в 60-е годы появляются машины военного назначения с цифробуквенными кодовыми названиями. Перечислять все выдающиеся советские ЭВМ было бы долго и скучно, мне гораздо интереснее разобраться, что откуда росло. С другой стороны, информация о технических характеристиках ЭВМ, местах и годах их разработки, количестве выпущенных машин и т. д. не представляет никакого секрета. Все это нетрудно найти в интернете. Вот несколько ссылок:

http://50.uginfo.sfedu.ru/technic.htm#m_220

https://www.kramola.info/vesti/protivostojanie/sovetskaja-vychislitelnaja-tehnika-istorija-vzleta-i-zabvenija

http://ru.uacomputing.com/stories/emerging-of-soviet-predecessors-of-personal-computers/

http://ru.pc-history.com/evm-mir-2.html

Попробуем представить, как происходила разработка этих замечательных машин. В разных научных и проектных организациях возникали творческие коллективы, вырабатывавшие новые проекты, зачастую в рекордно короткие сроки и при скудном финансировании. Коммунистическая партия, безосновательно претендовавшая на тотальный контроль над всеми процессами в стране, уследить за всеми просто не могла. Да и сама партия теперь была не та, что раньше. Обжегшись на войне, она пусть не сразу, но постепенно пересмотрела свои методы руководства, перестала рассматривать каждый болт через призму классовых интересов (иногда ложно понимаемых). Инженеры, ученые и руководители научных учреждений получили свободу, а там, где свобода, творческие идеи будут появляться как бы сами собой.

Разумеется, не все творческие идеи одинаково плодотворны. В качестве хрестоматийного примера - ЭВМ «Сетунь» (1959-1965 гг., выпущено 50 шт.) - единственная в мире ЭВМ, работавшая в троичной системе счисления. Все последующие машины работают исключительно в двоичной системе. То есть разработка оказалась тупиковой, однако никого за это не посадили и не расстреляли (после смерти Сталина (1953 г.) тюрьмы и расстрелы практически сошли на нет).

Однако, если мы хотим изучать историю серьезно, а не просто перечислять даты и факты, то мы должны понять, что такое счастливое положение дел не могло продолжаться бесконечно.

В нормальном капиталистическом обществе буржуй, кровопийца-эксплуататор - это прежде всего инвестор и организатор производства. Он дает людям ресурс N1, которого все хотят, но на всех не хватает, - рабочие места - и этим оправдывает свое существование. КПСС этих функций не имела и была, таким образом, не просто эксплуататорским, а чисто паразитическим классом. Однако на словах и на бумаге нужно было как-то объяснить народу, для чего Партия нужна, и была придумана формулировка: «КПСС - руководящая и направляющая сила общества». А уж если такие слова сказаны, их нужно было подтверждать делом, так что вмешательство КПСС во все дела в стране, вплоть до самых мелких, было неизбежно. Но одно дело стоять над душой, допустим, у сталевара и каждый день его пилить: «давай больше металла, давай еще больше металла», и совсем другое лезть в сложные инженерные вопросы, тем более в такой отрасли техники, которой каких-то 10 лет назад просто в помине не было. Тогдашние руководители коммунистической партии и советского государства, будучи сами людьми с весьма посредственным уровнем образования, на вычислительную технику и программирование смотрели косо и в лучшем случае терпели их присутствие рядом с собой, но не более того. И то, что произошло в конце 60-х годов XX века, рано или поздно должно было произойти.

В один прекрасный день нашлась умная голова, которая придумала использовать новейшие ЭВМ для прогнозирования экономического развития страны. И какие бы ни использовали методики прогнозирования, результаты получались неутешительные. Мы-то теперь видим, что безрадостные прогнозы сбылись, мы теперь даже можем понять глубинные причины этого… Но тогдашнее правительство и ЦК КПСС во главе с Политбюро ничего такого видеть-слышать не желали, и в итоге (в конце 1960-х годов) было принято преступное (на мой взгляд) решение о прекращении собственных разработок вычислительной техники и об использовании вместо них американских образцов. Это решение не было осуществлено полностью: страна нуждалась в собственных компьютерах военного назначения. А вот «на гражданке» место оригинальных русских машин заняли СМ-4 (американская PDP-11), болгарский ИЗОТ (американский VAX - потомок PDP-11 с увеличенной разрядностью), ЕС ЭВМ (американские IBM/360). Новейшим представителем последнего семейства была ЕС-1060 - мне довелось иметь с ней дело во время обучения в институте. Эта машина занимала зал размером с 3 хороших трехкомнатных квартиры и потребляла электроэнергию, как троллейбус. По этим параметрам ЕС-1060 была близка к БЭСМ-6, но значительно уступала последней по боевым возможностям. К тому же эта машина была почти постоянно неисправна и работала буквально несколько часов в год. Другие «цельнотянутые из США» машины были ничуть не лучше. Но самое плохое было то, что к этим машинам было крайне скудное программное обеспечение, а то, что имелось, было низкого качества.

За названиями IBM/360 и PDP/11 стоят не какие-то конкретные машины, а проекты, или, в нашей тогдашней терминологии, - научно-исследовательские и опытно-конструкторские разработки (НИОКР). Целью этих работ было создание семейств машин, больших и малых соответственно, программно-совместимых в пределах своего семейства и выполненных на общей конструктивной базе, в отличие от советских ЭВМ того времени. Эти машины имели новую для 60-х годов элементную базу - микросхемы. Имея такое преимущество в «железных» технологиях, американцы, однако, до начала 70-х годов так и не смогли это преимущество полностью реализовать - построить компьютер, радикально превосходящий наши БЭСМ. Не будем наивными и не будем думать, что они из чисто благотворительных побуждений снабжали нас передовыми проектами. Рассматривая их машины с точки зрения архитектуры, мы ничего передового в них не найдем. Если допустить, что американцы знали о БЭСМ-6 (ну англичане-то знали, purquois pas американцам знать?), то приходим к очевидному выводу: они сознательно сливали нам устаревшие и бесперспективные разработки. Они при этом ничего не теряли, более того: получали какие-то копейки там, где уже не надеялись получить прибыль. Если же не ограничиваться только вычислительной техникой и посмотреть шире, то мы увидим, что делали они это далеко не в первый раз.

Несколько слов о ЕС ЭВМ. ЕС расшифровывается: Единая Серия. Предыдущие наши компьютеры, даже те, что имели сходные названия, не образовывали серий. Чаще всего они были несовместимы ни программно, ни хотя бы конструктивно: для каждой новой машины создавались заново все периферийные устройства и даже чисто конструктивные элементы вплоть до последней дверцы шкафа. Это замедляло проектирование и усложняло эксплуатацию. Очевидно назрела задача унификации: для всех машин сделать общий набор периферийных устройств, унифицированные модули оперативной памяти, которые можно было бы подключать по одному или несколько, и ряд процессоров, различающихся только количественно, но программно совместимых и выполненных в едином конструктивном стиле. Тогда, если ранее купленная машина перестанет вас удовлетворять, ее можно будет апгрейдить путем замены процессора или добавления памяти, как мы делаем сейчас с нашими настольными компьютерами. Идея, как мы видим, вполне здравая. Плоха была не идея - плоха была реализация: вместо того чтобы воплотить в новых процессорах все лучшее, что было наработано отечественными специалистами, использовали далеко не лучший американский образец.

Очень важный и интересный вопрос: разрядность древних ЭВМ. У современных машин разрядность принимает значение из ряда: 8, 16, 32 или 64, но так было не всегда. В 50-е годы представление о том, что разрядность должна быть равна целой степени двух, еще не сформировалась. В машинах 50-х годов вся информация была организована в виде машинных слов, длина которых (она же разрядность) была достаточна для представления числа с плавающей запятой. Так, например, «Стрела» имела машинное слово длиной 43 бит, из которых 35 - мантисса и 6 - порядок, а БЭСМ-6 - 48 бит. Ни шестнадцатиразрядных, ни тем более восьмиразрядных машин в те времена никто не строил: ведь машины были нужны для научных и инженерных расчетов, а такие расчеты требуют точности. Ячейки памяти имели размер машинного слова, а система команд процессора продумывалась так, чтобы каждая команда также вписывалась в машинное слово.

Смешной вопрос: а какова разрядность ЕС ЭВМ? Из десяти современных специалистов десять ответят: 32. Ответ неверный. Ширина выборки из оперативной памяти, она же разрядность машинного слова, действительно, была равна 32, но разрядность арифметико-логического устройства у первых машин серии могла быть 16 и даже 8. Но это не главное. Оперативная память этих машин имела байтовую организацию, так что чтение и запись в память могли производиться байтами, полусловами (2 байта - 16 бит) и словами (4 байта - 32 бит). Процессор же, помимо этого, мог обрабатывать и числа с плавающей запятой в формате двойного слова (8 байт - 64 бита). Такая структура памяти, удобная для решения как физико-математических, так и планово-экономических задач, унаследована всеми компьютерами последующих эпох, так что IBM-360 и соответственно ЕС можно считать частично древними машинами, а частично средневековыми.

Аналоговая техника во второй половине XX века

Мы говорим в основном про цифровую вычислительную технику, однако давайте вспомним и аналоговую. В середине XX века она отказалась от валиков, колесиков и рычажков, перешла полностью на электрический, а затем на электронный принцип действия. Это позволило во-первых, увеличить быстродействие, и во вторых, придать машинам способность к программированию (программирование чаще всего осуществлялось путем вставки проводов со штекерами в нужные гнезда на лицевой панели прибора). Но ценой ускорения работы стала возросшая погрешность вычислений. (Для несведущего в технике читателя последнее утверждение может показаться диким, но это действительно так).

В 50-е годы аналоговые и цифровые машины, выражаясь языком конного спорта, «шли ноздря в ноздрю»: цифровые машины хотя и обещали более быстрое решение сложных задач, но сами были громоздки и дороги. Даже самая «простая» цифровая машина тех времен занимала порядочных размеров комнату (скорее зал) и потребляла очень много энергии. В нашей стране было построено семейство аналоговых машин МН («модель нелинейная»): некоторые представители этого семейства были в настольном исполнении, размером как большой радиоприемник, и цена была такова, что позволяла выпускать эти машины в огромных количествах. Но ничто не могло помочь преодолеть главный недостаток аналоговых ЭВМ - их «умственную ограниченность». Аналоговая машина непригодна для решения народнохозяйственных задач, т. к. там нужно хранить множество показателей, причем хранить с абсолютной точностью. Операция сложения на аналоговой машине как-то получается, умножение ей уже дается с большим трудом, зато такая машина великолепно справляется с операциями дифференцирования и интегрирования. Поэтому аналоговые ЭВМ долго применялись для решения задач моделирования непрерывных процессов, таких как обтекание воздухом самолетного крыла или полет ракеты в околоземном пространстве. Решение таких задач на цифровых ЭВМ было поначалу сложно и дорого, главным образом из-за необходимости привлекать к работе программистов. Однако позже в области цифровых ЭВМ и их программирования имел место большой прогресс, и аналоговая техника стала терять рынок. К 1960-м годам доля аналоговых ЭВМ в общем объеме переработки информации стала уже ничтожно мала. Аналоговые машины еще строились, но во все меньших и меньших количествах. Строят их и сейчас, уже в единичных количествах, в основном в качестве лабораторных стендов для учебных заведений.

Три поколения цифровых электронных вычислительных машин

Электронные цифровые вычислительные машины первого поколения (1950-х годов) строились на электронных лампах. Они (и лампы, и машины) были громоздки и нежны и потребляли очень много электроэнергии. Так, например, «Стрела» потребляла мощность 150 кВт (как трамвай на полном ходу), из них ровно половина - 75 кВт - приходилась на вентиляторы, обеспечивавшие охлаждение машины. Это несколько странно, потому что у большинства других компьютеров доля энергозатрат на охлаждение гораздо меньше. Устанавливались они в специально оборудованных зданиях или помещениях - вычислительных центрах (ВЦ). Последняя ламповая машина - «Урал-4» - строилась на Пензенском заводе до 1964 г.

Электронные лампы были дороги в изготовлении, имели небольшой срок службы и ограниченное быстродействие, так что стоимость каждой вычислительной операции, произведенной с помощью ламп, была высока. Не хотелось бы втравливать читателя в дебри экономики, но придется хотя бы на первоклашечно-промакашечном уровне кое-какие вопросы затронуть. Денег стоит не только сам компьютер - определенных расходов потребует и его повседневная эксплуатация. Компьютер нужно установить в соответствующем здании, которое размещается на соответствующем земельном участке… Здание нужно обеспечить освещением, отоплением, охраной. Компьютер потребляет электроэнергию - это понятно всем, но еще нам потребуется бумага, перфокарты или то, что придет им на смену, и, извините за вульгарные технические подробности, спирт… Мало-мальски грамотному экономисту даже не потребуются подробные расчеты, чтобы прийти к очевидному решению: каков бы ни был наш бюджет, компьютеры нужно строить в минимальном количестве, но максимально мощные. В идеале - один-единственный компьютер, но такой, в котором каждая лампа работала бы с максимальной отдачей (в начале 50-х годов только так и поступали). Дробление бюджета на N компьютеров меньшей мощности привело бы к тому, что суммарный объем работы, которую эти компьютеры могут поднять за все время своей службы, уменьшится, не говоря уж о том, что какие-то задачи им будут просто не по зубам.

В 1947 г. был изобретен полупроводниковый прибор - транзистор, способный выполнять функции, аналогичные функциям электронных ламп, но более компактный, надежный и энергоэкономичный. Первые транзисторы (точечные) оказались неудовлетворительными, затем еще несколько лет потребовалось для налаживания массового производства транзисторов, и в итоге ближе к 1960 г. появились ЭВМ второго поколения (подчеркиваю: мы говорим о поколениях электронных цифровых машин, а не компьютеров вообще).

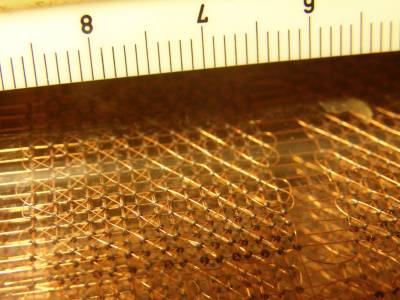

На следующих фото - платы (типовые элементы замены - ТЭЗ) советских транзисторных ЭВМ, датируемые 1969, 1981 и 1975 годами соответственно. Две последних, очевидно, были изготовлены как запчасти к машинам более раннего выпуска.

Далее перед нами сфотографированная с большим увеличением структура модуля оперативной памяти («куба») на ферритовых кольцевых сердечниках. Для сравнения в верхней части снимка - сантиметровая линейка. Датировать этот модуль можно лишь приблизительно: 60-е-70-е годы XX века.

Применение транзисторов радикально снизило стоимость вычислительной операции, но переписывать начисто всю ту экономику, которой мы только что коснулись, было еще рано - это произойдет в 70-е годы, с появлением больших микросхем. Однако уже на втором поколении ЭВМ стало возможным разделение двух направлений развития вычислительной техники: с одной стороны, никто не отменял «больших» ЭВМ с новыми техническими возможностями, казавшимися немыслимыми всего несколько лет назад, и с другой стороны, был начат выпуск более простых малых ЭВМ (мини-ЭВМ), которые количественно и качественно не уступают большим ЭВМ предыдущего поколения, но при этом компактны и дешевы, так что их можно строить в больших количествах. Примерами малых ЭВМ являются рассмотренные выше «Наири», «Проминь» и МИР.

В начале 60-х годов XX века были изобретены микросхемы, применение которых позволило продолжить тенденцию к уменьшению размеров и стоимости компьютеров. Так появилось третье поколение ЭВМ, но о нем чуть позже, потому что его появление совпало во времени с наступлением средних веков.

На земле, в небесах и на море

Оказывается, еще в 1950-е годы в нашей стране велись опытно-конструкторские работы по теме автоматизации управления поездами. Эти работы закончились неудачей, так что сейчас едва ли кто-либо о них помнит. О причинах неудач нам вряд ли расскажут, но нетрудно построить несколько рабочих версий.

Версия N1: тогдашняя элементная база не позволяла построить компьютер, который можно было бы установить на локомотив. Как мы уже знаем, электронные лампы были слишком хрупки. Даже в тепличных условиях вычислительного центра они часто перегорали, а неизбежная на любом транспортном средстве вибрация погубила бы их в первый же день. Транзисторы не были склонны к перегоранию, но у них были свои враги: скачки питающего напряжения и повышенная температура. В 50-е годы транзисторы были германиевые, они уже при +50оС чувствовали себя неуютно, в отличие от нынешних кремниевых, которые выдерживают и +100. Это гипотеза, лежащая на поверхности, но есть и еще. В то время не было достаточной научной базы. Такая база для «больших» компьютеров в то время еще только складывалась, а для управляющих машин не было практически ничего. И версия N3: у тогдашних руководителей наших железных дорого просто были другие серьезные вещи на уме. Эти вещи называются СЦБ: сигнализация, централизация и блокировка. Различные устройства для обеспечения безопасности движения поездов по дорогам в нашей стране появлялись практически с начала строительства железных дорог. В начале XX века, с развитием электротехники и аппаратуры связи, эта работа активизировалась, Великая Отечественная война ее замедлила, после войны нужно было наверстывать упущенное… К 70-м годам СЦБ на наших железных дорогах выросли в крупнейшую и сложнейшую в мире техническую систему производственного назначения. По интеллектуальному уровню эта система не имела равных в мире, но к вычислительной технике она не имеет отношения.

Так это было или не так, но сегодня ни одного поезда без машиниста мы в России не увидим - не только

на обычной железной дороге, но и в метро, где, казалось бы, условия для автоматизации идеальные. А вот во Франции о наших неудачах не знали, так что парижское метро уже давно работает без машинистов.

Сказанное не означает, что наши железнодорожники поставили крест на любой компьютеризации. Однако следующий опыт применения ЭВМ на ЖД транспорте относится уже к 70-м годам - к этой теме я надеюсь вернуться, когда наша история дойдет до средних веков. А сейчас нам нужно не пропустить интересные события, развернувшиеся в рассматриваемую нами эпоху на другом участке фронта - в промышленности.

Основная промышленная машина - станок. Разновидностей станков на свете много, но все они имеют общие черты. В станке имеется рабочий орган - шпиндель с вращающимся валом: в токарном станке в шпиндель зажимается заготовка, в остальных станках - инструмент, например сверло или фреза. Также имеется система взаимно-перпендикулярных направляющих, обеспечивающая движение заготовки относительно инструмента по координатам. В простейшем случае движение осуществляется вручную, но это не значит, что до появления станков с ЧПУ все станочные работы производились вручную и никакой автоматизации не было. Практически с начала XX века на технологически передовых заводах имелись станки, способные выполнять операции без непосредственного участия человека:

* Агрегатный станок имел множество шпинделей, которые в процессе обработки детали совершали какое-то несложное движение, чаще всего просто вперед и назад. Типичная продукция такого станка - корпус дизельного двигателя с множеством одинаковых, регулярно расположенных отверстий для крепления к нему других частей двигателя. Перенастройка такого станка на выпуск других деталей могла вылиться в весьма трудоемкую работу, но на автомобильных или авиационных заводах это была обычная практика.

* Копировальный станок. В нем имеется копир - металлическая пластина, край которой имеет форму, соответствующую форме будущей детали. При обработке детали инструмент движется, повторяя форму этого края. Типичная продукция такого станка - корпус артиллерийского снаряда: он имеет форму как будто несложную, но

криволинейную. Голыми руками такую форму, да еще и с требуемой точностью, не выдержать, а по копиру - запросто. Провести инструмент по копиру в простейшем случае можно вручную, но эту задачу совсем несложно и автоматизировать. Чтобы перестроить такой станок на выпуск другой детали, достаточно сменить копир, а это работа сводится к тому, чтобы отвинтить и завинтить пару болтов. То есть копир - своего рода программа, а копировальный станок может рассматриваться как станок с аналоговым программным управлением.

* Станок-автомат имеет револьверную головку с небольшим числом инструментов, например 6 или 8. При обработке очередной детали все инструменты вступают в работу поочередно, и каждый инструмент описывает цикл - простое движение по замкнутому прямоугольнику: подход к детали - обработка - отход - возврат в исходную точку.

Типичная продукция такого станка - детали несложные, но изготавливаемые в массовом количестве, например болты. Такой станок программируется. Программа, написанная инженером-технологом на бумаге, представляет собой таблицу координат по паре для каждого инструмента. Рабочий-наладчик вводит эту программу в станок путем установки в нужное положение каких-то рукояток, упоров, концевых выключателей и т. д. Для выполнения программы в станке имеется несложная электрическая система, включающая и выключающая электромоторы перемещения инструмента.

* Станок с цикловым программным управлением похож на автомат и отличается тем, что инструмент может выполнять не один цикл движения, а много, и каждый цикл со своими координатами. Так можно изготовить деталь ступенчатой формы. Программа, имеющая вид пар чисел (координата подхода к детали и координата рабочего хода), набивается на перфоленту. Имеющийся в станке командный аппарат читает перфоленту команда за командой - последовательно от начала к концу, без перескоков и возвратов, и по каждой команде осуществляет движение инструмента на заданную координату. Командный аппарат может представлять собой несложную логическую схему, которую можно собрать на электромагнитных реле. Настоящий компьютер для этого необязателен, поэтому такие станки были обычны уже в середине XX века, когда компьютеры только начали появляться.

Однако в 60-е годы люди начали задумываться о создании станка, способного выполнять более сложные операции, например обработку деталей не ступеньками, а по прямой под произвольным углом к координатным осям, а в идеале и по окружности. Для решения этой задачи нужен уже полнопрофильный компьютер, и постепенно эта задача стала реальностью. Так появились станки с числовым программным управлением (ЧПУ), близкие к тем, которые используются и сейчас.

Прогресс не стоит на месте: транзисторы 60-х годов стали более надежными и экономичными, чем их «старшие братья» 50-х. Новая элементная база позволила сделать компьютер более прочным и «жизнестойким», так что стало возможно его эксплуатировать не только в условиях заводского цеха, но и на автомобиле, корабле или самолете. В отдельные классы выделились собственно вычислительные машины, получающие задачи и данные для их решения от людей и выдающие результаты для прочтения опять-таки людьми, и управляющие машины, которые, в отличие от вычислительных, напрямую, без посредничества человека, взаимодействуют с каким-то техническим оборудованием. Управляющие машины приходятся родными бабушками нашим нынешним микроконтроллерам. Разработка управляющей машины для народного хозяйства УМ-1-НХ была начата в ленинградском КБ-2 еще в 1958 г., т. е. практически сразу с началом массового промышленного выпуска отечественных транзисторов, а с 1963 г. эта машина выпускалась серийно на Электромеханическом заводе. Она имела настольное исполнение, содержала 8000 транзисторов (сравните с 6200 ламп в «Стреле», хотя обе эти машины содержали еще много других компонентов) и потребляла 150 Вт - ровно в тысячу раз меньше «Стрелы». К сожалению, сравнивать эти машины по производительности не получается: слишком разные задачи, разные условия эксплуатации.

На следующих фото - экспонаты петербургского Музея артиллерии, инженерных войск и войск связи - специализированные ЭВМ 9В53 и 9В51, предназначенные для наведения тактических баллистических ракет. Они датируются 60-ми годами XX века.

9В51 принята на вооружение в 1966 г., устанавливалась в автофургоне - кунге, но автофургон обеспечивал только транспортировку машины на позицию: работа машины была возможна только на стоянке. Машина двухадресная, с фиксированной запятой. Логическая часть этой ЭВМ была собрана на феррит-транзисторных ячейках, память (оперативная и постоянная) - на ферритовых сердечниках, ввод данных - с клавиатуры, вывод - на сегментный индикатор (как в калькуляторах, только крупнее) и на телетайп. http://www.phantom.sannata.ru/forum/index.php?t=13330&a=do_print

По 9В53 информации еще меньше, но по внешнему виду мы видим, что устройством вывода были неоновые цифровые индикаторы. Похожие индикаторы тогда ставились в корабельные навигационные компьютеры… и в автоматы для продажи билетов на электрички.

В 1980-е годы многие навигационные задачи на флоте и в авиации решались с помощью компактных и надежных бортовых компьютеров. В обиход вошел термин «авионика» - электроника для авиации. Дальнейшее разделение направлений развития привело к созданию микро-ЭВМ, которые, при некоторой ограниченности интеллектуальных возможностей, могли бы работать прямо в заводских цехах, взаимодействуя с установленным там оборудованием. Они стали предвестниками очередной смены исторических эпох.

Программирование в древние времена

Вот мы и подошли к вопросам, которые в большинстве книг и статей по истории вычислительной техники либо совсем не затрагиваются, либо рассматриваются очень поверхностно.

Рассматривая первобытные компьютерные времена, мы заметили, что никакого программирования тогда не существовало. Протокомпьютер или эокомпьютер, выезжая за ворота родного завода, уже нес внутри себя все, что было нужно для решения задачи. Люди так жили и к этому привыкли, кое-кто и до сих пор не избавился от этого стереотипа мышления. И вот нате вам здрассьте: новейший цифровой компьютер, который все называют не иначе как чудом техники, на поверку оказывается никчемной кучей железа - сам по себе он даже 2+2 сложить не может! Чтобы решить хоть какую-то задачу, нужна, оказывается, ПРОГРАММА. А что за программа, зачем и почему, где ее взять? (и кстати почём, если не секрет?)

Так неожиданно для всех возникла профессия программиста. Возникла как будто на пустом месте - и сразу в полный рост.

Элементной базой первых компьютеров были, как мы уже знаем, электромагнитные реле и электровакуумные лампы. Они не были придуманы на пустом месте - это были серийные промышленные изделия, использовавшиеся в аппаратуре связи. Стало быть, кто-то эти изделия создавал, и кто-то их применял. То есть первые компьютеростроители были обычными инженерами: электриками и электронщиками. А программистов среди них не было. Программирование не преподавалось в институтах, по нему не было книг. Между тем работа программиста требует специальных знаний, которые мало коррелируются с обычной математикой и практически совсем не коррелируются ни с электротехникой, ни с электроникой. Объем же этих знаний находится на пределе того, что доступно человеку с очень высоко развитым интеллектом! То есть программирование - самостоятельная профессия: ты можешь изучить целенаправленно именно эту профессию и работать в ней много лет, не нуждаясь ни в чем другом.

Теперь вспомним, что мы говорили выше о стоимости вычислительной операции в древние времена. Стояло требование: программа должна содержать как можно меньше операций, а профит (польза, прибыль) от каждой операции должен быть максимальным. Таков был категорический императив древнего программирования (да и в средние века мало что изменилось). Любая попытка игнорировать или обойти этот императив ничем, кроме убытков, закончиться не могла. Но мы-то, конечно, понимаем, что задача извлечь максимум профита из ограниченного ресурса никогда и нигде в мире не была слишком простой. Стало быть, и людей, способных эту задачу решать, никогда и нигде в мире не было слишком много. Отсюда очевидна необходимость налаживать профессиональный отбор и подготовку таких специалистов. А теперь прикиньте: допустим, летом 1951 года, предвидя запуск М-1 и МЭСМ, мы объявим прием абитуриентов по специальности «программирование» - к работе они приступят не раньше 1956-го года, а еще потребуется года три, чтобы понять, насколько они годны и насколько годна методика их подготовки…

Программирование в древности было мастерством на грани искусства. Программистов было мало, а для непрограммиста разработка программ представлялась чем-то совершенно запредельным.

Задачи и особенности применения ЭВМ

ЭВМ 1950-х годов были вычислительными машинами в полном буквальном смысле, т. е. решали задачи, связанные со сложными математическими и физическими расчетами, и по всем инженерным решениям были «заточены» под эти задачи: вспомним, что и ячейки памяти, и арифметико-логические устройства имели большую разрядность (40..52), обеспечивающую представление чисел с плавающей запятой.

Стоп-стоп, а как же бухгалтерия? Ведь еще в XIX веке именно она была самой компьютеризированной областью человеческой деятельности?

А никак. С того самого XIX века в бухгалтерии мало что изменилось. В крупных, технологически продвинутых конторах пользовались счетно-аналитическими машинами. Те, у кого «труба пониже и дым пожиже», арендовали счетно-аналитическую машину на машинносчетной станции, совершенно аналогично тому как колхозы не имели собственных тракторов, а арендовали их на машинно-тракторной станции. Для остальных выбор был между арифмометром и деревянными счётами. И такое положение дел сохранилось до 1980-х годов. В СССР профессия бухгалтера не была ни особо престижной, ни высокооплачиваемой. Работали там люди со средним образованием, порой даже неполным, и обеспечивать их настоящими компьютерами никому не казалось необходимым, так что в следующий раз мы про бухгалтерию вспомним только в главе «Новое время».

И только в 1960-е годы люди начали задумываться об использовании ЭВМ для решения задач в области экономики и управления производством, а еще чуть позже - и для других задач, в которых вычисления играли второстепенную роль.

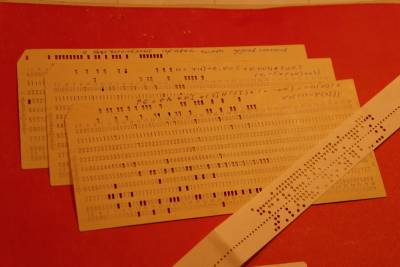

Для большинства ученых, инженеров и студентов вычислительная техника была все еще совершенно недоступна и неизвестна. Для тех счастливчиков, у кого на работе или в учебном заведении имелись какие-то ЭВМ, основным режимом работы был пакетный: задачи, решаемые в интересах множества пользователей, объединялись в пакет, который решался последовательно от начала к концу. Чтобы обеспечить работу ЭВМ без простоев, нужно было к моменту запуска иметь все надлежащие данные в готовности. Подготовку данных целесообразно было производить параллельно с подготовкой самой машины, т. е. на отдельном устройстве. Занимались этим специальные работники - операторы подготовки данных - на специальных рабочих местах, оснащенных устройствами подготовки данных. Основным носителем данных для ввода в ЭВМ была перфокарта. УПД на перфокартах (не путать с перфоратором - устройством вывода данных из ЭВМ на перфокарты) представляло собой электромеханический прибор с клавиатурой наподобие пишущей машинки. При нажатии клавиши на перфокарте пробивались определенные отверстия. При этом оператор не видел результатов нажатия. Во избежание ошибок по завершении пробивки каждой перфокарты (обычно она содержала одну строку исходного текста программы) оператор должен был ввести строку еще раз, при этом пробивка не производилась, а производилась только сверка нажатых клавиш с данными, пробитыми на перфокарте. Если обнаруживалось несовпадение, то перфокарта исправлению не подлежала и браковалась, и весь процесс приходилось повторять заново (и не факт что с успешным результатом). По окончании подготовки всех данных колоду перфокарт из лотка УПД переносили на считыватель, подключенный непосредственно к ЭВМ. Когда машина была готова, ее запускали. Результаты расчетов выводились на принтер алфавитно-цифровое печатающее устройство (АЦПУ) и выкладывались в ящик, где пользователь мог их взять. С момента подачи заявки на вычисления до получения ответа могло пройти несколько дней.

На следующем фото - несколько перфокарт с текстом программы на языке Фортран и более прогрессивный носитель данных - перфолента:

Технология подготовки данных на перфокартах была весьма затратна, и в 60-е годы XX века для замены перфокарт были предложены более прогрессивные носители данных: магнитные ленты (МЛ) и магнитные диски (МД). Соответственно были созданы устройства подготовки данных на магнитных лентах (УПДМЛ) и на магнитных дисках (УПДМД). Оператор, работавший на этих устройствах, видел каждый введенный знак на экране непосредственно после ввода и мог исправлять ошибки по мере их обнаружения, что позволило сократить трудоемкость работы и уменьшить нервную нагрузку на работников.